漠然とGCP怖いな(気づかずに課金されそう、サービスが広大で理解しきれなさそうなど)と思っていたけど、ちょっとでも慣れようと色々触ってみることにした。

データを格納された状態からしかBigQueryに触ったことがなかったので、データを格納する各種手法を手を動かしてやってみる。

概要

この記事では、まず単純な以下の方法を試してみる。

A. BigQueryにローカルのCSVを読み込む

B. BigQueryにCloud StorageのCSVを読み込む

手順

※ Google Cloudのアカウントを作成して、プロジェクトを作成した状態からスタート

※ 操作はCloud Consoleを使用した

A. BigQueryにローカルのCSVを読み込む

① データセットを作成する

データセットの概要 | BigQueryドキュメントに、以下の記載がある。

データセットは、特定のプロジェクト内に含まれています。データセットは、テーブルとビューへのアクセスを整理して制御するために使用される最上位のコンテナです。テーブルまたはビューはデータセットに属していなければなりません。したがって、データを BigQuery に読み込む前に、1つ以上のデータセットを作成する必要があります。

そのため、まずはデータセットを作る。

データセットの作成 | BigQueryドキュメントに作成時の注意点や作成手順が記載されているので、これを参照しながら作成した。

1) プロジェクトを選択した状態で「データセットを作成」を選択

2) データセット名とロケーションを入力

ロケーションはデータを保存するサーバの地理的な場所のことで、データセットのロケーション | BigQueryドキュメントに色々注意点が記載されている(データセット作成後にロケーションは変更することはできず、データの読み込み先と同じロケーションである必要がある, 料金もロケーションによって異なるなど)。今回はのちに利用するCloud StorageをUSにしていたため、デフォルトのUSマルチリージョンとした。

② 読み込み用データの準備

今回は、気象庁HPからダウンロードした東京都の2021年1月の気象データを読み込み用データとした。

スキーマの指定 | BigQueryドキュメントやCloud Storage からの CSV データの読み込み 制限事項 | BigQueryドキュメントに以下のような制限が記載されているので、それに合わせて整形する。

・ 列名には、英字(a-z、A-Z)、数字(0-9)、アンダースコア(_)のみを使用できる ・ CSV データは UTF-8 でエンコードされている必要がある ・ DATE 列の値に区切りとしてダッシュ(-)を使用し、YYYY-MM-DDの形式にする

今回は下記のようなCSVとなった。

date,ave_temp,max_temp,min_temp,max_wind_speed,wind_direction,weather

2021-01-01,4.4,10.5,-1.3,3.1,北北東,快晴

2021-01-02,4.8,10.8,0.1,4.7,北北東,快晴

…③ データを読み込む

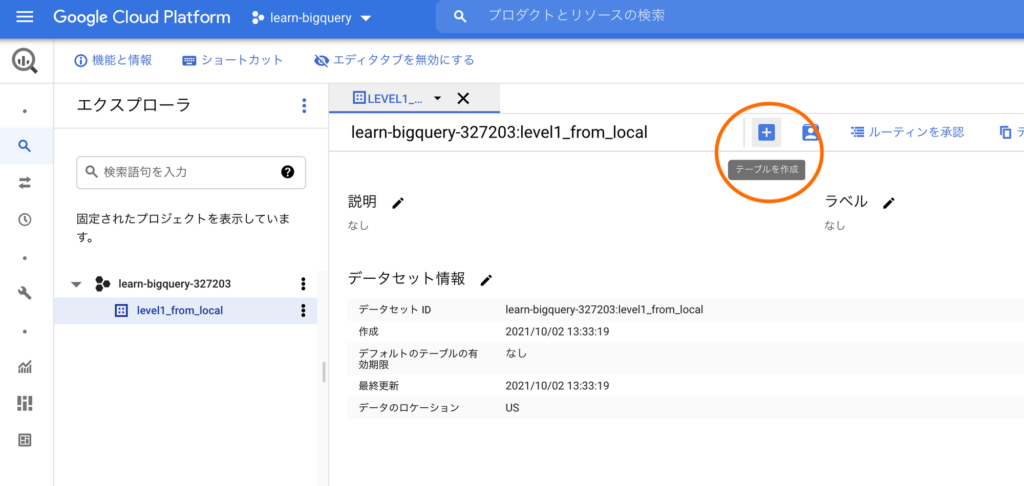

テーブルを作成して、CSVデータを読み込んでいく。

1)データセットを選択した状態で「テーブルを作成」をクリック

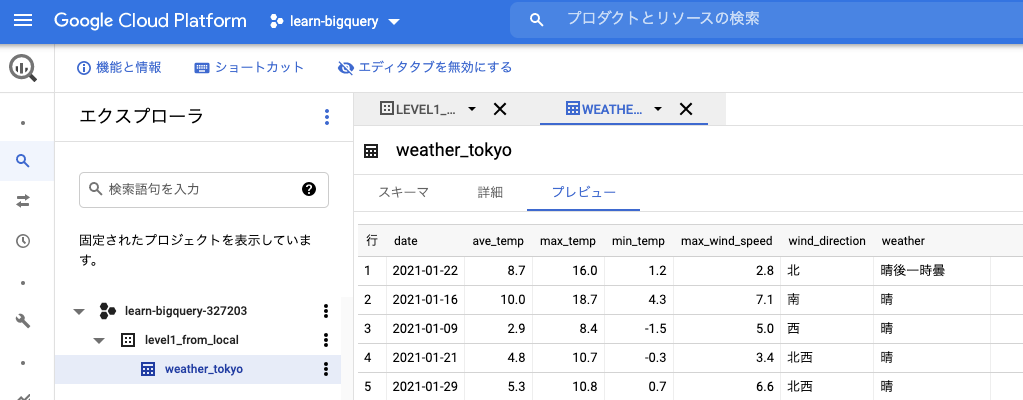

2)ローカルからCSVをアップロードし、テーブル名等を入力

スキーマは自動検出でやってみた。

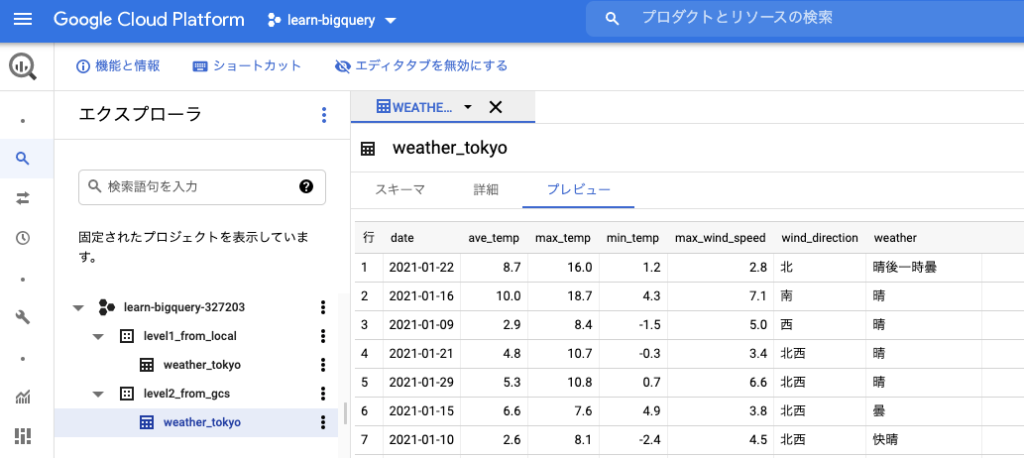

3) 無事、テーブルにデータが読み込まれた。

自動検出としていたが、データの型も問題なく判定されていそう。

B. BigQueryにCloud StorageのCSVを読み込む

A.の方法から半歩進んで、GCPのストレージサービスであるCloud Storageに格納したCSVデータからBigQueryに読み込んでみる。

① Cloud StorageにCSVデータを入れる

まずは読み込み用CSVデータをCloud Storageにアップロードする。

1) Cloud Storageにバケットを作成する

バケットはオブジェクトの格納先(オブジェクトは格納する個々のデータのこと。今回だとCSVデータ)。Cloud Storageに保存するデータはすべてバケットに格納する必要があるので、まずはバケットを作成する必要がある。

ストレージ バケットの作成 | Cloud Storageドキュメントを参照しながら作成した。

データの保存場所については、データセットのロケーション | BigQuery ドキュメントに注意点の記載がある。BigQueryデータセットと読み込み元のCloud Storageバケットは同じロケーションとする必要がある。今回、BigQueryデータセットをUSマルチリージョンとしていたので、バケットをus-east1としてみた。

2) Cloud StorageにCSVデータをアップロードする

1)で作ったバケット内に、今回はフォルダを作成し、その中にローカルからCSVファイルをアップロードした。

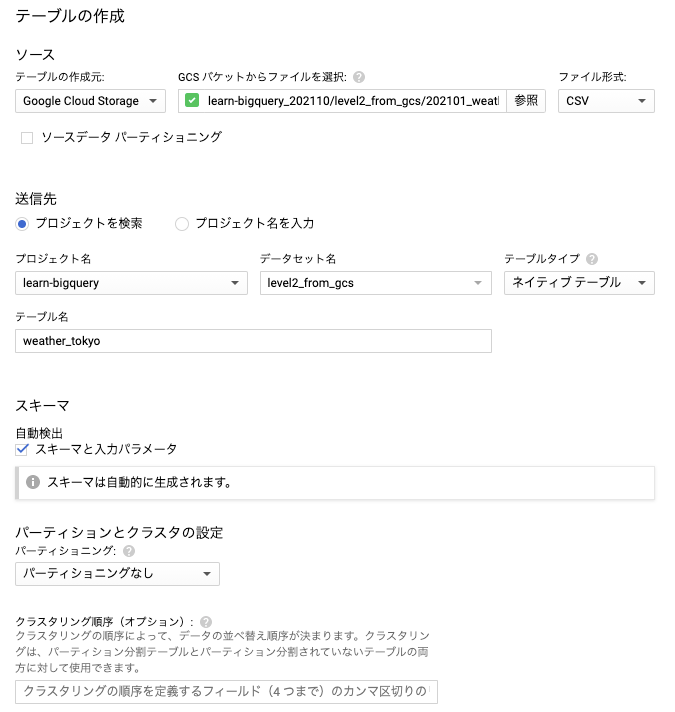

② Cloud StorageからBigQueryに読み込む

基本的にA. のローカルからアップロードした場合と同じ手順でアップロードできる。ソース部分のみGCSに変えている。

無事、テーブルにデータが読み込まれた。

次:

今回、ローカルあるいはCloud Storageから手動でBigQueryにデータを読み込む方法を試した。単発の読み込みなら今回の方法でも良いのかもしれないが、データが新しく生成され、都度読み込みを行いたいケースも多そうだ。次回はその場合の読み込みを試してみる。